MicroCeph як альтернатива MinIO: посібник по налаштуванню

Нещодавно команда MinIO перевела відкритий проект у режим обслуговування і більше не буде приймати жодних змін. Це означає, що нові функції або вдосконалення не будуть додані до MinIO, а існуючі проблеми — згідно з оновленням — не будуть активно розглянуті. Хоча MinIO пропонував зручний для розробників підхід до об’єктного зберігання (S3) протягом багатьох років, це оновлення означає, що проект, ймовірно, не зможе встигати за новітніми досягненнями у технологіях зберігання. Отже, для розробників, які прагнуть залишитися на передовій об’єктного зберігання та скористатися блоковим і файловим зберіганням, яке буде наступним кроком?

Ceph встановив стандарт як надійне, гідне виробництва відкритий зберігач даних протягом більше десяти років. Однак деякі користувачі вважають, що інструменти, які поставляються з Ceph, важкі у використанні; тому кілька років тому ми представили MicroCeph як спрощений і зручний спосіб розгортання Ceph.

Незважаючи на ім’я Micro, нічого не бракує. MicroCeph — повнофункціональний Ceph, з тією ж архітектурою масштабування, а також протоколами блочного (RBD), файлового (CephFS, NFS) і об’єктного (S3, Swift) зберігання. Позитивною різницею є те, що MicroCeph пропонує простіше розгортання, масштабування та операції в день-2.

Від моменту випуску MicroCeph його впровадження стало широким. Відтепер ви знайдете його в розгортаннях від однодаткових середовищ розробки та CI до розгортань у виробництві масштабом до кількох ПетаБайт, що дозволяє організаціям керувати постійно зростаючими потребами в зберіганні даних. Для розробників, які шукають альтернативу MinIO, MicroCeph може стати вашим рішенням.

Налаштування вашої альтернативи MinIO: як почати з MicroCeph

У цьому посібнику ми пройдемо кроки, щоб створити кластер Ceph на одному вузлі. Ми також пояснимо, як увімкнути RGW (Rados Gateway), щоби ви могли використовувати API S3, як ви могли б зробити це з MinIO.

Спочатку вам знадобиться один вузол або віртуальна машина, щоб спробувати. Із MicroCeph, що постачається як Snap, ви не зобов’язані використовувати Ubuntu OS – будь-яка машина Linux з snapd підійде!

Почніть зі встановлення останньої стабільної версії MicroCeph:

sudo snap install microceph --channel=squid/stable

Якщо snap завантажено і встановлено, нам потрібно проініціалізувати кластер Ceph:

sudo microceph cluster bootstrap

Тепер ми можемо перевірити, чи успішно завершено ініціалізацію:

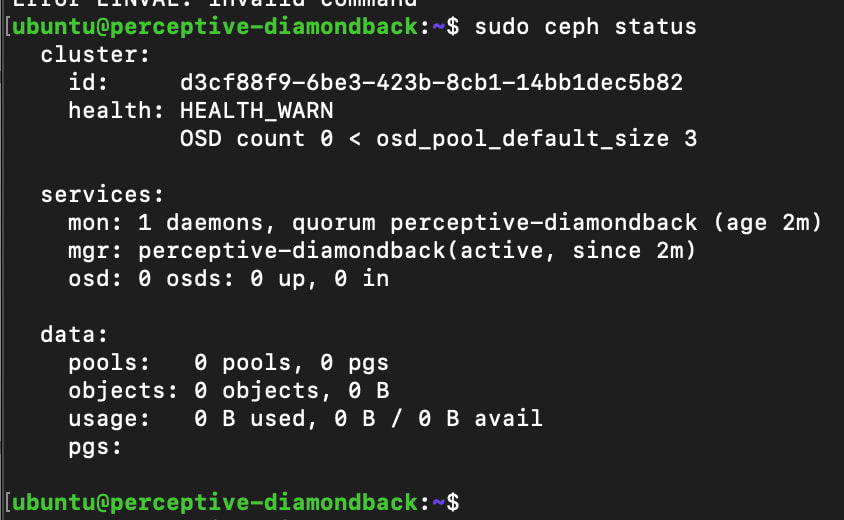

sudo ceph status

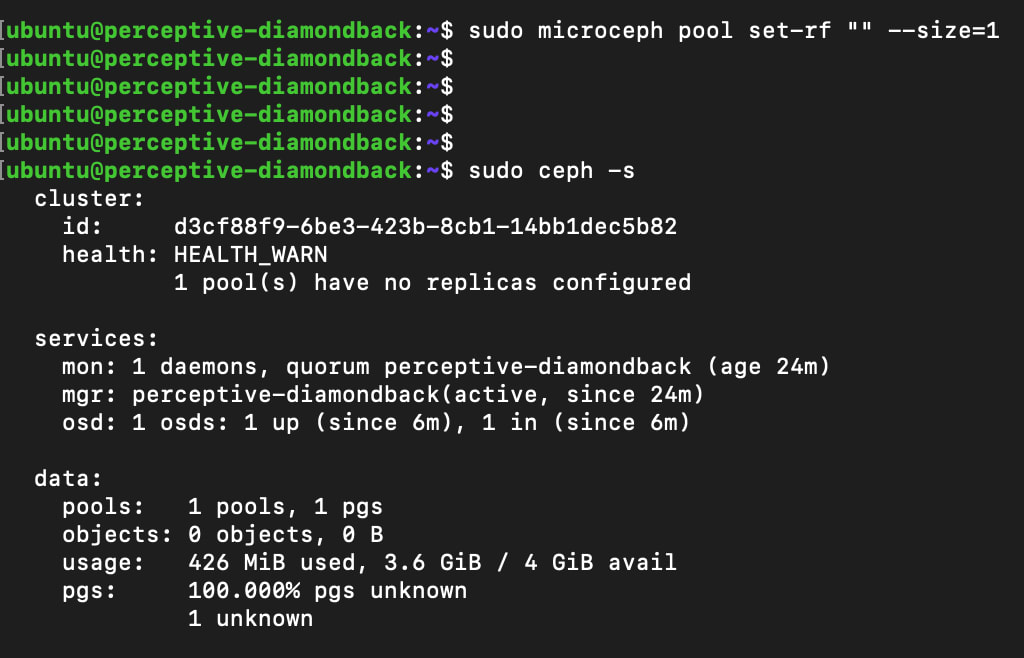

Ви повинні побачити вихід, подібний до наведеного нижче. Не турбуйтеся з приводу HEALTH_WARN на цьому етапі, це очікувано, оскільки в нас є лише один Монітор (MON) у кластері та жодних демонів об’єктного зберігання (OSDs).

Як і будь-яка система зберігання, Ceph потребує дисків для ефективної роботи. У цьому сценарії ми додамо один файл-подібний диск, щоб розпочати. Це ідеально для тестування та CI – але не ідеально у виробництві. Для нього слід використовувати реальні диски, тобто флеш або обертові носії. Дізнайтеся більше про те, які диски використовувати для MicroCeph в нашій документації.

Щоб додати файл-подібний диск, введіть наступне:

sudo microceph disk add loop,4G,1

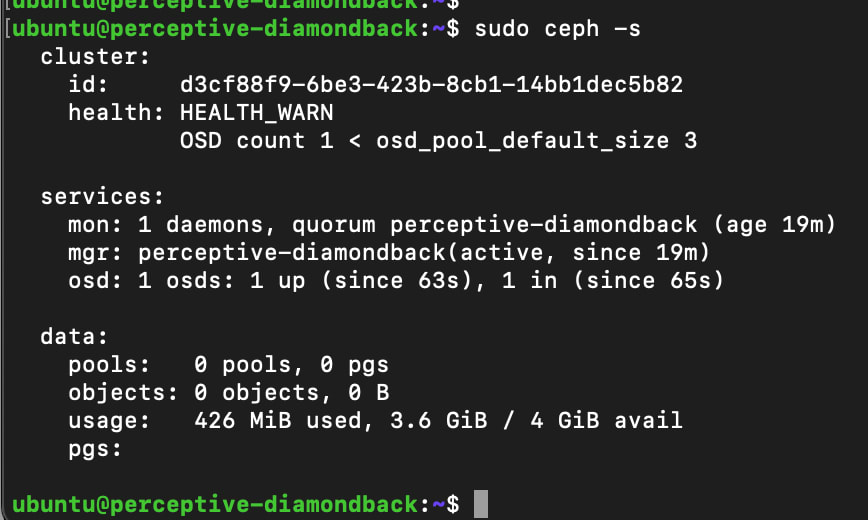

Ще раз ми можемо перевірити статус кластера. Тут ми можемо бачити, що OSD успішно додано.

Ще один крок, який нам потрібно здійснити в цій тестовій конфігурації, це налаштувати фактор реплікації. Це ніколи не слід робити у виробництві, або з даними, які вам важливі: якщо один диск зламається, ви зіткнетеся з втратою даних.

Щоб налаштувати фактор реплікації, введіть наступне:

sudo microceph pool set-rf "" --size=1

Хоча є попередження, його можна ігнорувати на даний момент, оскільки це просто тестове середовище.

Увімкнення RGW

Наступний крок – увімкнення RGW, щоб ми могли використовувати S3 API.

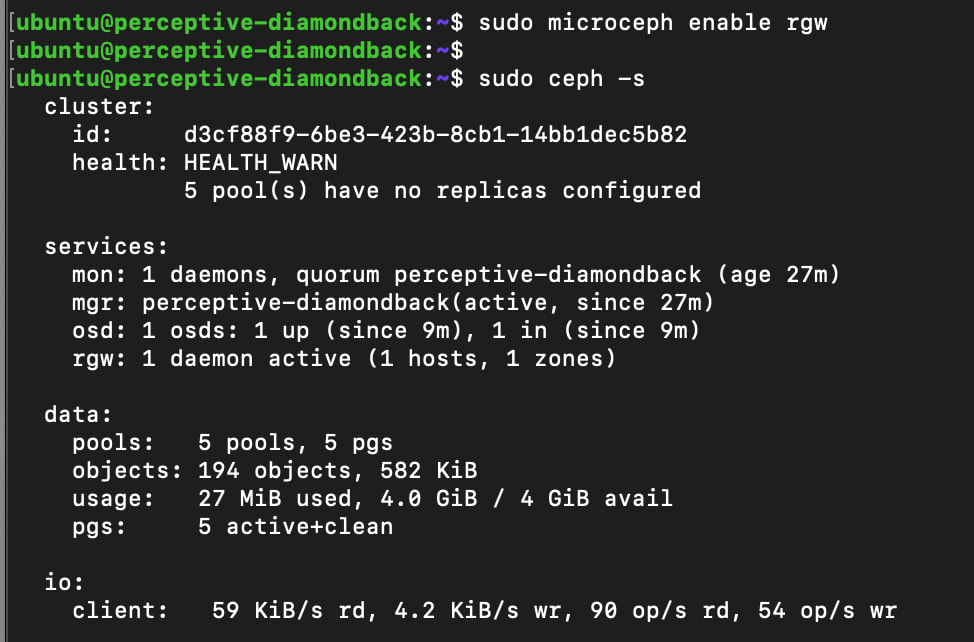

sudo microceph enable rgw

MicroCeph впорається з кількома завданнями на цьому етапі: він розгорне демон RGW і створить пули, необхідні для метаданих об’єктів та самих об’єктів.

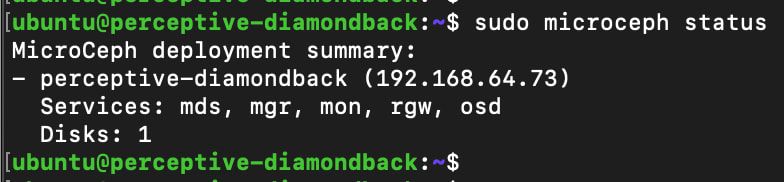

Ми можемо побачити ці зміни в кластері, перевіривши статус кластера знову:

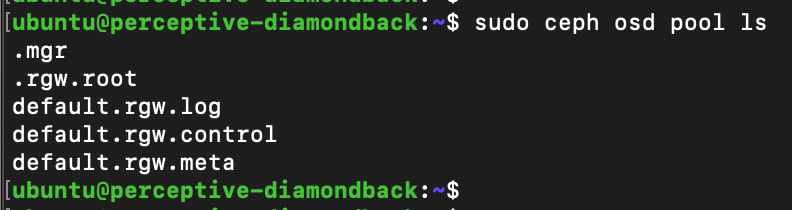

А також, перелічуючи пули в кластері:

sudo ceph osd pool ls

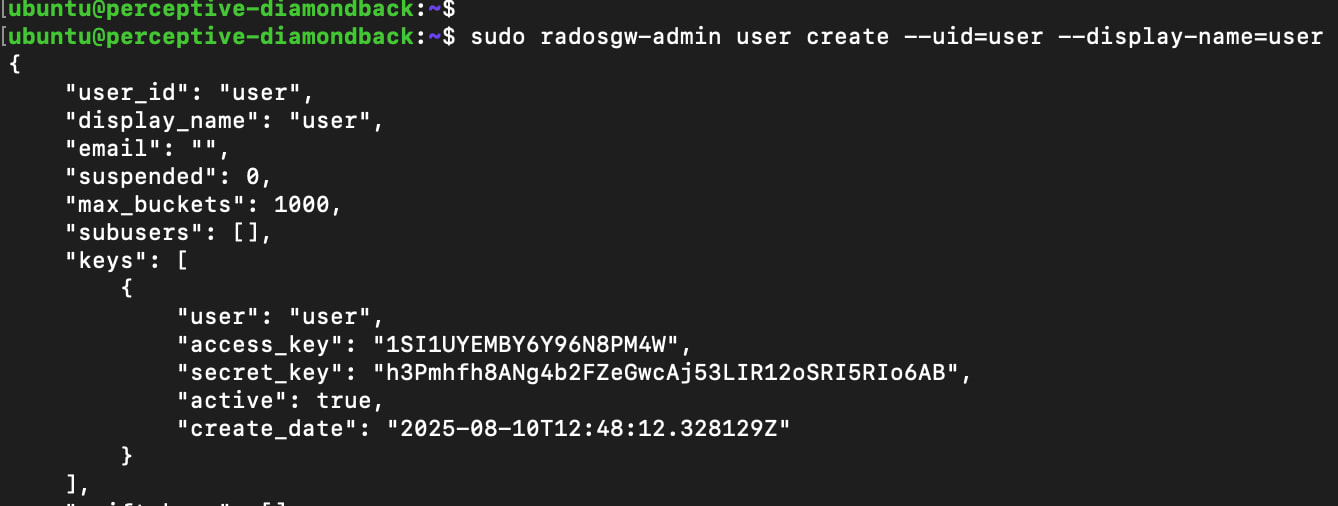

Далі створіть користувача RGW, щоб ми могли надати доступ до зберігання в кластері:

sudo radosgw-admin user create --uid=user --display-name=user

Ця команда надасть вихід, подібний до наведеного нижче. Вашій програмі знадобляться access_key і secret_key для взаємодії з кластером, наприклад, для створення бакетів, а також для завантаження та скачування об’єктів.

Ми можемо швидко дізнатися IP-адресу RGW, перевіривши статус MicroCeph:

sudo microceph status

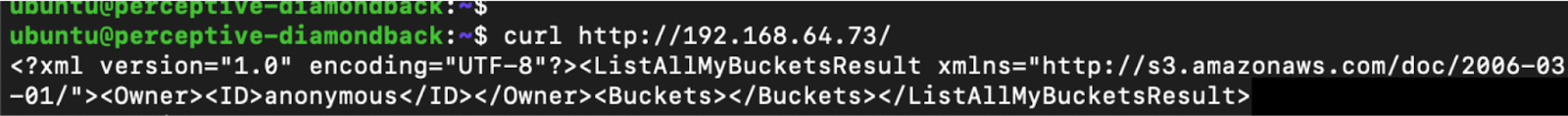

А потім ми можемо протестувати кінцеву точку API, використовуючи curl:

curl http://<IP Адреса>

Тут ми бачимо, що кінцева точка API відповідає – готова до того, щоб ви могли створювати бакети, а також почати завантаження та скачування файлів.

Є багато способів взаємодії з об’єктним зберіганням. Інструменти, такі як s3cmd, boto3, s5cmd або cyberduck є популярними. Альтернативно, ваша програма може приймати access і secret keys для безпосереднього управління об’єктами, що зберігаються у сумісному бакеті S3.

MicroCeph як альтернатива MinIO

Звісно, цей посібник тільки дає уявлення про те, на що здатен Ceph. Масштабування з одного вузла — дуже простий процес, і в кінцевому підсумку кластер може бути масштабовано до декількох петабайт, якщо це знадобиться. І на відміну від MinIO, не потрібне жодне інше рішення, якщо вам також потрібне блочне або файлове зберігання! Дізнайтеся, як виконати установку з декілька вузлів в нашій документації.

Чудовою річчю MicroCeph snap є те, що, як частина зобов’язань Ubuntu та Canonical щодо тривалої підтримки (LTS), його можна підтримувати до 15 років з моменту випуску LTS. Якщо вам цікаво дізнатися, як ви можете використовувати MicroCeph у довгостроковій перспективі, спробуйте наш блог про використання MicroCeph як зберігання для Kubernetes.

Що таке Ceph?

Ceph — це рішення для зберігання, визначене програмним забезпеченням (SDS), розроблене для задоволення потреб об’єктного, блочного та файлового зберігання як маленьких, так і великих дата-центрів.

Це оптимізоване і легке в інтеграції рішення для компаній, які вважають відкритий код новою нормою для зберігання даних блочного зростання, об’єктних сховищ та дата-озер.

Як оптимізувати витрати на хмарне зберігання

Хмарне зберігання – це чудово, воно на запит, легко реалізувати, але чи є це найефективнішим підходом для великих, передбачуваних наборів даних?

Досліджуйте справжні витрати на зберігання даних у публічному хмарі та як відкритий Ceph може надати ефективну альтернативу.

Посібник по програмно визначеному зберіганню для підприємств

Ceph — це рішення для зберігання, визначене програмним забезпеченням (SDS), розроблене для задоволення потреб об’єктного, блочного та файлового зберігання як маленьких, так і великих дата-центрів.

Досліджуйте, як Ceph може замінити власні системи зберігання в підприємствах.

Продуктивне, надійне та економічне зберігання з Ceph

Canonical Ceph спрощує весь життєвий цикл управління розгортанням, налаштуванням та експлуатацією кластера Ceph, незалежно від його розміру чи складності. Встановлюйте, моніторьте та масштабуйте хмарне зберігання з великою взаємодією.

Дізнайтеся, як Ceph масштабується без зусиль та економічно ›